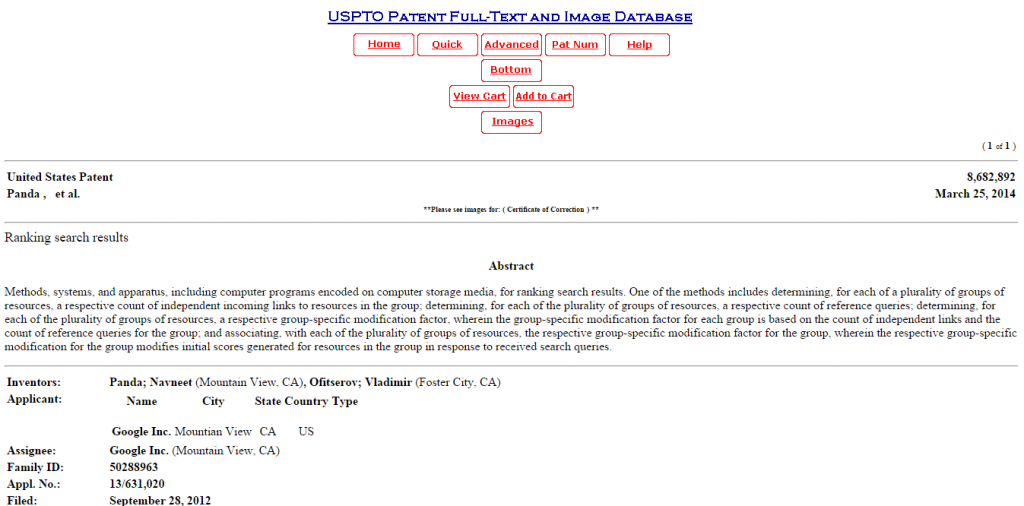

Panda - это специальный алгоритм поисковика Google, реализованный в феврале 2011 года и получивший патент в сентябре 2012 года. Целью новой разработки американской компании было изменить процесс ранжирования сайтов. Согласно новой концепции сайты низкого качества с плохим контентом должны были опускаться ниже сайтов с качественным контентом в верхней части SERP. В июле 2015 г. вышла версия Panda 4.2.

В результате применения нового алгоритма вверх резко поднялись сайты новостного характера и социальные сети. Напротив, сайты, изобилующие рекламой резко опустились вниз в поисковой выдаче. Девиз нового алгоритма Google «Довольный пользователь — довольная Панда». Сразу же после начала применения нового алгоритма в англоязычном Интернете свои позиции потеряло примерно 12% сайтов. В первую очередь наказание задело сайты с краденым контентом.

Новые изменения должны были повысить качество сайтов. При этом Google обращает внимание не на отдельные страницы ресурса, а на весь сайт в целом или на один из его важных разделов. Для того чтобы веб-ресурс оказался на выше своих конкурентов в выдаче, следует полностью избегать плагиата. Оценивается количество не уникального контента на странице и на сайте вообще.

Но одной уникальности для Google недостаточно. Необходимо, чтобы все тексты были логичными и продуманными. Их содержание должно быть полезным и излагать тематику сайта по существу. Чем меньше «воды» на сайте, тем лучше. Google пессимизирует сайты, на которых, по его мнению, размещены поверхностные и неконкретные статьи.

Новый алгоритм также требует, чтобы все тексты на сайте были четко структурированы и имели необходимые заголовки и подзаголовки. Если текст к тому же еще и хорошо сверстан, то это будет дополнительным плюсом сайта. Помимо этого для алгоритма важны и другие факторы: умеренное количество рекламы; качество и количество интернет-ресурсов, на которые ссылается данный сайт; отказы и т.п.